La interacción entre personas y sistemas automatizados crece a gran velocidad, y con ella surgen preguntas sobre quién responde cuando algo falla. En este contexto, la empresa Google DeepMind presentó el 12 de febrero de 2026 un nuevo marco de delegación inteligente de IA, pensado para reforzar la confianza, la trazabilidad y la responsabilidad dentro de redes digitales cada vez más complejas.

Según el gigante tecnológico Google, los agentes de inteligencia artificial ya no funcionan solo como asistentes simples. Hoy participan en mercados, cadenas de suministro y sistemas organizacionales donde delegan tareas, toman decisiones y coordinan procesos.

Este crecimiento ha aumentado la presión por crear protocolos que permitan entender quién decide qué, cómo se ejecuta cada acción y quién responde por los resultados.

Google DeepMind: Transparencia, reputación y control humano

El modelo propuesto plantea que delegar tareas en sistemas de IA implica transferir tanto autoridad como responsabilidad. Para evitar confusiones, el marco establece roles claros, objetivos definidos y mecanismos formales de supervisión.

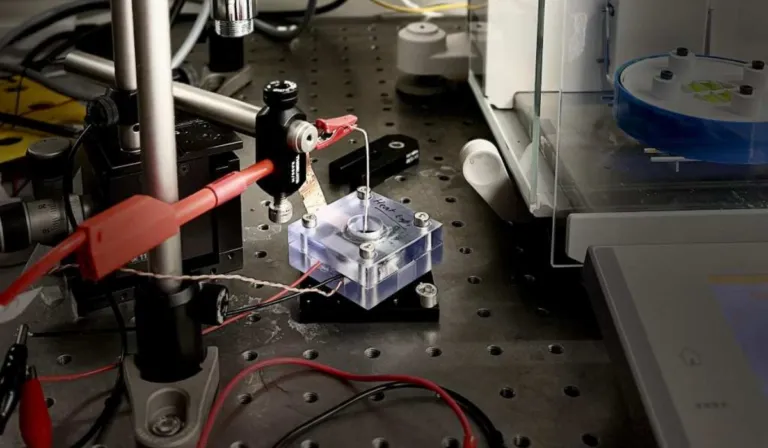

Entre las herramientas planteadas destacan sistemas de reputación, verificaciones técnicas, pruebas criptográficas y monitoreo constante, con el objetivo de auditar decisiones sin exponer información sensible. También se promueven registros que permitan seguir la cadena de decisiones y distinguir entre fallos accidentales y malas prácticas.

Uno de los riesgos que busca resolver este esquema es la difusión de responsabilidad, cuando múltiples agentes participan en una tarea y nadie asume las consecuencias. Para ello, se plantean límites técnicos y contractuales que obliguen a detener procesos cuando exista ambigüedad o riesgo.

El marco también reconoce desafíos sociales importantes, como la despersonalización de decisiones o la posible pérdida de habilidades humanas por exceso de automatización. Por eso insiste en mantener supervisión humana en puntos críticos y en involucrar a instituciones y reguladores en el diseño de estos sistemas.

La propuesta marca un cambio de enfoque: pasar de automatizaciones opacas a redes verificables, donde la inteligencia artificial pueda colaborar sin perder de vista el control humano y la confianza pública.

Con información de Infobae.