¿Qué tiene que ver la computación analógica con la inteligencia artificial?

El crecimiento de la inteligencia artificial ha traído avances sorprendentes, pero también un problema cada vez más evidente: su alto consumo de energía.

Algunas estimaciones señalan que una sola consulta extensa en ChatGPT puede gastar el doble de electricidad que un hogar promedio de Estados Unidos en un minuto.

Si ese consumo se multiplica por miles de millones de consultas diarias y se suma el costo energético del entrenamiento de los modelos, el impacto es enorme.

Ante este panorama, investigadores buscan alternativas que permitan hacer la IA más sostenible. Una de las propuestas más prometedoras es la computación analógica en memoria, una tecnología que podría reducir el gasto energético hasta mil veces.

Computación analógica y una forma distinta de hacer cálculos

Un estudio reciente, encabezado por Tianyi Chen, profesor asociado de ingeniería eléctrica e informática en Cornell Tech, junto con especialistas de IBM y del Rensselaer Polytechnic Institute, plantea una solución innovadora.

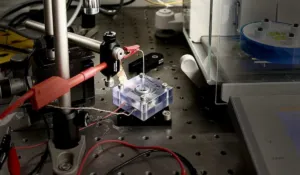

La computación analógica en memoria utiliza chips analógicos capaces de almacenar y procesar datos en el mismo lugar, evitando el constante traslado de información entre la memoria y el procesador que caracteriza a los sistemas tradicionales.

Según Chen, este enfoque “aprovecha la física para realizar cálculos matemáticos de manera instantánea, sin mover los datos”, lo que se traduce en un ahorro energético enorme y abre la puerta a una nueva generación de inteligencia artificial más eficiente.

Entrenar IA con menos energía

Uno de los principales retos de esta tecnología era el entrenamiento de los modelos.

El hardware analógico puede presentar imperfecciones, como ruido o pulsos eléctricos irregulares, que afectan la precisión del aprendizaje.

Para resolverlo, el equipo desarrolló una versión analógica de la retropropagación, el algoritmo clave en el entrenamiento de IA.

El resultado es un método llamado Residual Learning, que añade una capa de corrección en tiempo real para compensar las fallas del hardware. De esta forma, los modelos pueden entrenarse con una precisión similar a la de los sistemas digitales, pero consumiendo mucha menos energía.

“Compensamos dinámicamente las imperfecciones naturales del hardware para mantener el entrenamiento en el camino correcto”, explicó Chen. Este avance fue presentado en diciembre durante la conferencia NeurIPS 2025.

Un futuro más sostenible para la inteligencia artificial

La computación analógica podría transformar la forma en que se desarrolla y utiliza la inteligencia artificial.

Con un consumo energético mucho menor, sería posible llevar modelos avanzados a dispositivos médicos, tecnología vestible, sensores industriales y robots autónomos, áreas donde hoy el alto gasto de energía es una limitación.

Como siguiente paso, el equipo planea adaptar esta metodología a modelos de código abierto y trabajar con la industria para escalar la tecnología. Para Chen, el potencial es claro: esta investigación puede marcar un cambio real hacia una inteligencia artificial más eficiente, accesible y sostenible.